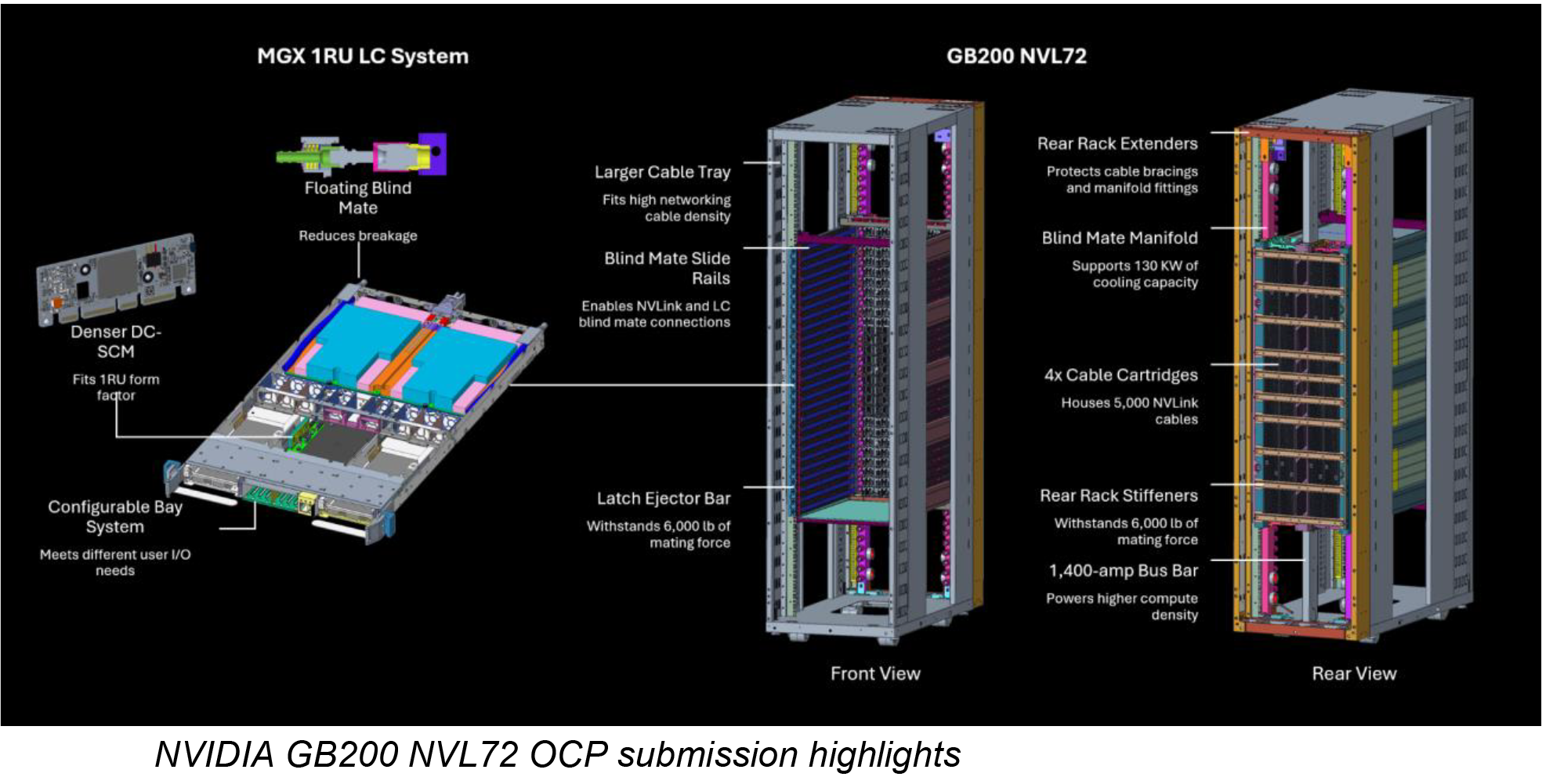

Nvidia предоставила свои конструкции стоек GB200 NVL72 и вычислительных/коммутационных лотков в проект Open Compute Project (OCP), что позволило членам OCP создавать свои конструкции на основе графических процессоров Nvidia Blackwell. Компания делится ключевыми элементами дизайна своей высокопроизводительной серверной платформы, чтобы ускорить разработку открытых платформ центров обработки данных, способных поддерживать энергоемкие графические процессоры следующего поколения Nvidia через сеть Nvidia.

В основе этого вклада лежит система GB200 NVL72, включающая до 72 графических процессоров GB100 или GB200. Nvidia делится важными электромеханическими проектами, включая подробную информацию об архитектуре стойки, системе охлаждения и компонентах вычислительного лотка. Система GB200 NVL72 имеет модульную конструкцию, основанную на архитектуре Nvidia MGX, которая объединяет 36 процессоров Grace и 72 графических процессора Blackwell в стоечной конфигурации. Эта конфигурация обеспечивает домен NVLink из 72 графических процессоров, что позволяет системе работать как один массивный графический процессор.

На мероприятии OCP Nvidia продемонстрировала новый общий эталонный дизайн GB200 NVL72. Он был разработан совместно с Vertiv, ведущим производителем систем электропитания и охлаждения, известным своим опытом работы в вычислительных центрах обработки данных с высокой плотностью размещения. Этот новый эталонный дизайн сокращает время развертывания для поставщиков облачных услуг (CSP) и центров обработки данных, использующих платформу Nvidia Blackwell.

Благодаря этой эталонной архитектуре центрам обработки данных больше не нужно создавать специальные конструкции электропитания, охлаждения или размещения, специфичные для GB200 NVL72. Вместо этого они могут положиться на передовые решения Vertiv для компактного управления питанием и энергоэффективного охлаждения. Такой подход позволяет центрам обработки данных быстрее развертывать кластеры GB200 NVL72 мощностью 7 МВт по всему миру, сокращая время внедрения до 50%.

«Nvidia в течение многих лет вносила значительный вклад в стандарты открытых вычислений, включая свою высокопроизводительную вычислительную платформу, которая была основой нашего сервера Grand Teton в течение последних двух лет», — сказал Йи Цзюн Сон, вице-президент по разработкам Meta. . «Поскольку мы продвигаемся вперед, чтобы удовлетворить растущие вычислительные потребности искусственного интеллекта в масштабе, последние разработки Nvidia в области проектирования стоек и модульной архитектуры помогут ускорить развитие инфраструктуры и внедрение искусственного интеллекта во всем секторе».

Помимо аппаратного обеспечения, Nvidia расширяет поддержку стандартов OCP с помощью своей сетевой платформы Spectrum-X Ethernet. Соответствуя спецификациям, разработанным сообществом OCP, Nvidia ускоряет подключение к центрам обработки данных с использованием искусственного интеллекта, позволяя организациям поддерживать согласованность программного обеспечения для сохранения предыдущих инвестиций.

Сетевые достижения Nvidia включают в себя ConnectX-8 SuperNIC, который будет доступен для OCP 3.0 в следующем году. Эти SuperNIC поддерживают скорость передачи данных до 800 Гбит/с, а их программируемая обработка пакетов оптимизирована для крупномасштабных рабочих нагрузок ИИ, что должно помочь организациям создавать более гибкие сети, оптимизированные для ИИ.

Более 40 производителей электроники работают с Nvidia над созданием платформы Blackwell. Мета, основатель OCP, является одним из известных партнеров. Meta планирует внедрить в OCP свою стоечную архитектуру Catalina AI, основанную на системе GB200 NVL72.

Тесно сотрудничая с сообществом OCP, Nvidia стремится обеспечить доступность своих проектов и спецификаций широкому кругу разработчиков центров обработки данных. Это позволит Nvidia продавать свои графические процессоры Blackwell и ConnectX-8 SuperNIC компаниям, которые полагаются на стандарты OCP.

«Основываясь на десятилетнем сотрудничестве с OCP, Nvidia работает вместе с лидерами отрасли над формированием спецификаций и проектов, которые могут быть широко внедрены в центрах обработки данных», — сказал Дженсен Хуанг, основатель и генеральный директор Nvidia. «Продвигая открытые стандарты, мы помогаем организациям по всему миру реализовать весь потенциал ускоренных вычислений и создать фабрики искусственного интеллекта будущего. »